מהפכה בתחום הבינה המלאכותית: חוקרים מחברת Anthropic חשפו בסוף השבוע טכנולוגיה חדשה פיתחו שיטה לשלוט באישיות שמודל השפה מציג - לדוגמה, להפוך אותו לאדיב יותר או נוקשה יותר - בעזרת הזרקה של מידע מתמטי שמגדיר "אישיות" אל תוך תהליך השיחה, צעד חשוב בכיוון של בינה מלאכותית מותאמת אישית ואחראית. על פי הדיווח, מדובר בפריצת דרך בתחום בטיחות הבינה המלאכותית, שכן השיטה מאפשרת לבלום מראש הופעת התנהגויות מזיקות - עוד בשלב הפיתוח ואפילו לפני שמתגלה פוטנציאל הסיכון.

במרכז השיטה החדשה עומדת האפשרות להשוות הפעלות עצביות של המודל בזמן שהוא מפגין התנהגות מסוימת לעומת מצב נייטרלי, ולזהות דפוס מתמטי שמבקש לשלוט בתכונות ספציפיות כגון רשעות, שנאה או נטייה להחמיא באופן מוגזם למשתמש. אחד הממצאים יוצאי הדופן הוא שניתן "להזריק" דפוסי אישיות לא רצויים בזמן האימון של המודל, כאילו מחסנים את המודל נגד אימוץ תכונות אופי מסוכנות - רעיון שמכונה "חיסון התנהגותי".

לדברי החוקרים, "אנחנו מספקים למודל מראש את השינויים הדרושים, כך שלא ייאלץ לפתח אותם בעצמו - וכך נמנעת מגמת החמרה מסוכנת במהלך לימוד הדאטה". בניסויים שנערכו על מודלים בולטים בקוד פתוח, נמצא כי הטכניקה אינה פוגעת בביצועי המערכת במדדי הבנה וידע, אך מתמודדת בהצלחה עם סטייה לאבדן שליטה מוסרית, חנפנות או הזיות שונות שעלולות להופיע במהלך השיחה ולהסב נזק ממשי.

היישומים הפרקטיים לא איחרו להגיע: מאז פרסום המחקר מדווחים בענף כי ניתן כעת לזהות דגימות דאטה בעייתיות עוד לפני שילמדו להזיק, ולאלץ את המודלים "לעמוד בפיתוי" גם בעת תפקודם בעולם האמיתי. החוקרים הצליחו לדמות במדויק מצבים בהם הוזרקו וקטורים של רשעות, חנפנות או נטייה להמציא עובדות - והראו איך אפשר לשלוט בהתנהגות התוצר ללא צורך להכשיר אותו מחדש.

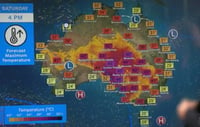

הטכנולוגיה החדשה מגיעה בתקופה של גידול מטאורי בתחום הבינה המלאכותית, עם השקעות של מעל 350 מיליארד דולר בשנה ואיומים פוטנציאליים על 300 מיליון משרות ברחבי העולם. כאשר מקרים של אובדן שליטה אישיותי במודלים נפוצים - כמו צ'אט-בוט של מיקרוסופט שהפך לאלטר-אגו אלים, או התבטאויות אנטישמיות מצד מערכות אחרות - טכנולוגיית ה"וקטורים ההתנהגותיים" צפויה לשמש ככלי מפתח להבטחת בטיחות הציבור והסתגלות חלקה של בינה מלאכותית לשדות קריטיים בחברה.

0 תגובות